DeepMind发布最新研究:AI也是可以相互合作的!

大数据文摘编辑部出品

从足球到战争,团队合作一直被认为是人类进步的基石。基于长期的共同目标大数据足球ai预测,削弱甚至牺牲个人利益,为人类作为一个共同体的最大利益做出了贡献。

DeepMind 也在尝试教 AI 学习这一点,并选择了最有可能表现出团队合作的评估方法——足球比赛。

今天凌晨,DeepMind 发布最新研究:证明在足球环境下,基于分布式智能体的持续控制训练框架,结合奖励通道的自动优化,可以实现多智能体端到端学习.

简而言之,DeepMind 为多个 AI 一起玩足球比赛搭建了环境。并且提前制定规则,奖励整个“足球队”,而不是鼓励某个“AI球员”的个人表现,从而促进整个球队的进步。这样就证明了AI也可以相互配合!

首先附上论文的链接:

这篇论文被 ICLP 2019 接受。

多方协作,通过竞争进行应急协调

多智能体通过合作实现团队的最优目标并不是一个陌生的话题。去年,OpenAI 发布了由五个神经网络组成的 DOTA 团战 AI 战队——OpenAI Five,并在 5v5 中击败了顶级人类。球员队伍。在比赛中,OpenAI Five 还表明,在以摧毁防御塔为前提的游戏中,牺牲“奴才”收益是可以接受的,即可以向长期目标优化 AI。

DeepMind 最近的研究进一步集中在多智能体领域。

他们组织了无数次 2v2 的 AI 足球比赛,并制定规则,只要一方得分或比赛超过 45 秒就结束比赛。

DeepMind 声称,通过分散的、基于组的训练,代理的行为可以进化:从随机的、简单的追球,到最后的简单“合作”。他们的研究还强调了在训练大规模多智能体以进行连续控制时遇到的几个挑战。

值得一提的是,通过设置简单的自动优化奖励,DeepMind 不鼓励个人,而是鼓励合作行为和团队整体绩效,可以促进长期的团队行为。

通过在研究中引入“基于个人折扣因素自动优化奖励的想法”,他们可以帮助他们的代理人从短视的培训方式转变为长期但更注重团队的培训模式。.

DeepMind 还进一步提出了一种基于博弈论原理的评估方案,可以在没有预定义评估任务或人工基线的情况下评估代理的性能。

具体想法

将足球比赛视为一个多智能体强化学习(MARL)过程,模拟一个交互环境,智能智能体通过学习与环境交互,进而优化其累积的奖励。MARL的主要思想是合作或竞争,或两者兼而有之。选择什么样的行为完全取决于“奖励奖励”设置。MARL 的目标是典型的马尔可夫完美均衡。一般意义是在随机博弈中找到一组达到均衡条件的混合策略。

具体含义是博弈参与者的动作策略具有马尔可夫特性,即每个玩家的下一步动作是根据对方的最后一个动作来预测的,而不是基于之前的动作历史。马尔可夫完美均衡是:根据这些参与者的行为找到动态均衡。

DeepMind 在 github 上发布了他们使用的 MuJoCo Soccer 环境,这是一个用于竞争性协作多智能体交互的开源研究平台,在机器学习社区中得到了相当广泛的应用。

github地址:

评估

相关游戏视频链接:

为了有效评估学习团队,DeepMind 选择优化评估方法。入选的团队都是此前通过不同评价方式产生的10个团队,每个团队都有250亿的学习经验。他们收集了 10 支球队的上百万场比赛情况。

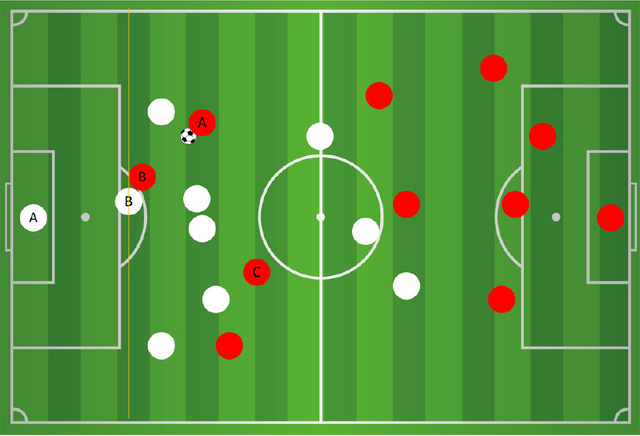

上图显示了支持团队的 3 名代理显示的成对预期目标差异。纳什均衡要求所有 3 个团队都具有非零权重,并且这些团队协作以展示具有非传递性能的不同策略,这在评估方案中不存在:团队 A 在 59.7% 的B队获胜或平局;B 队在 71.1% 的比赛中获胜或打平 C 队,C 队在 65.3% 的比赛中获胜或平局 A 队。它们显示了 A、B 队之间的示例比赛记录, 和 C 可以定性量化其策略的多样性。

在上图中,DeepMind 展示了一个典型的智能体行为轨迹:在步骤 5B 中,当智能体行为更加个人化时,我们观察到无论 blue1 的位置如何,blue0 总是试图自己运球。但在后期训练中,blue0积极寻求团队合作大数据足球ai预测,他的行为受到队友的推动,表现出高度的协调性。特别是在“8e10_left”比赛中,DeepMind 表示他们观察到连续两次传球(blue0 到 blue1 和防守者),这是人类足球中经常出现的 2 对 1 撞墙组合。

未来的研究

DeepMind的研究意义重大。将 2v2 足球引入多智能体协作是前所未有的。通过强化学习研究,通过竞争与合作来训练独立的智能个体,展示团队的协调行为。

本文还演示了一个基于连续控制的分布式集群训练框架,该框架可以结合奖励路径自动优化,从而在此设置中实现端到端学习。

它引入了一种将奖励方向从单一策略行为转变为长期团队合作的想法。引入了一种新的反事实政策评估来分析主体政策行为。评估突出了匹配结果的非传递性和对稳健性的实际需求。

DeepMind 的开源训练环境可以作为多智能体研究的平台,也可以根据需要扩展到更复杂的智能体行为研究,为未来的研究打下坚实的基础。

来自“ITPUB博客”,链接:如需转载,请注明出处,否则追究法律责任。

转载于:

-

大数据和人工智能如何选择,首先我们要搞懂两个问题

2022-05-11 -

看竞彩推荐,首选彩客网,用AI预测足球比赛结果

2022-04-06